人工智能知識介紹(1)

資料來源:西城區(qū)青少年兒童圖書館 發(fā)布日期時間:2016-03-09 瀏覽量:1149 次

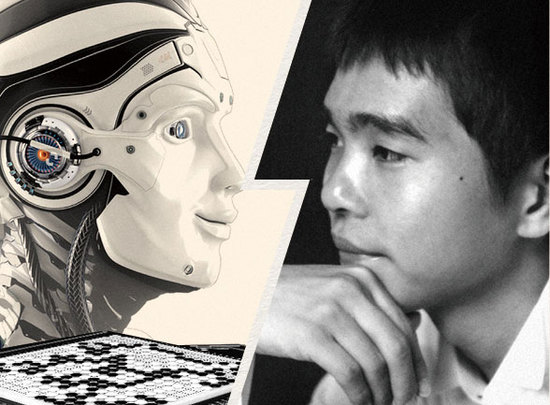

3月9日12點(diǎn),舉世矚目的谷歌圍棋(Alpha GO)挑戰(zhàn)李世石的“人機(jī)大戰(zhàn)”在韓國首爾鈡路區(qū)fourseasons酒店正式打響,有關(guān)“人工智能”的信息更是引發(fā)人們的關(guān)注。

Alpha GO主要功能

位于英國倫敦的谷歌旗下DeepMind公司的戴維·西爾弗、艾佳·黃和杰米斯·哈薩比斯與他們的團(tuán)隊,開發(fā)了一個叫“AlphaGo”的程序,利用“價值網(wǎng)絡(luò)”去計算局面,用“策略網(wǎng)絡(luò)”去選擇下子。訓(xùn)練這些深度神經(jīng)網(wǎng)絡(luò)的,是對人類專業(yè)棋局的監(jiān)督學(xué)習(xí)以及讓它和自己對弈的增強(qiáng)學(xué)習(xí)。

“AlphaGo”程序在和其他圍棋程序的對抗中獲得了99.8%的勝率,并且在一項競賽中以5比0的成績戰(zhàn)勝了歐洲圍棋冠軍。計算機(jī)程序能在不讓子的情況下,在完整的圍棋游戲中擊敗專業(yè)選手,這還是第一次。原本人們認(rèn)為,要到10年后人工智能才能達(dá)到這一成就。

系統(tǒng)原理

作為一種人工智能系統(tǒng),AlphaGo擁有兩個大腦,落子選擇器 (Move Picker)和棋局評估器 (Position Evaluator)。這也基于兩個深度神經(jīng)網(wǎng)絡(luò),policy network與value network。二者極大地降低了需要考慮的搜索空間的復(fù)雜度,前者降低搜索的廣度,后者降低搜索的深度,很像人腦在下圍棋時憑直覺快速鎖定策略的思維。

集合了3000萬種職業(yè)棋手的下法,數(shù)百萬次深度學(xué)習(xí)與自我對戰(zhàn),十分接近帶著直覺和第六感的人類大腦,能以57%的概率預(yù)測與其對陣人類的水平。

研發(fā)者表示,AlphaGo有自己學(xué)習(xí)和進(jìn)化的能力。人類在長時間的比賽中會因疲勞而犯錯,但電腦程序不會,人類可能一年只能下一千盤棋,而AlphaGo一天就能下一百萬盤。

網(wǎng)站名稱:北京市西城區(qū)青少年兒童圖書館中華人民共和國信息產(chǎn)業(yè)部網(wǎng)站備案號:京ICP備05085450號 |